Inhaltsverzeichnis

1 Was ist Multikollinearität?

Multikollinearität ist im Kontext der multiplen linearen Regression eine zu hohe Korrelation von zwei oder mehr erklärenden Variablen (x-Variablen) miteinander vorliegt. Wenn dem so ist, könnte man die inhaltliche Frage stellen, ob zwei miteinander hoch korrelierte unabhängige Variablen nicht sogar dasselbe messen und damit ein Weglassen einer der beiden denkbar wäre.

2 Was hat Multikollinearität für Folgen?

Die Regressionskoeffizienten sind bei vorhandener Multikollinearität verzerrt geschätzt. Die übliche Interpretation eines Regressionskoeffizienten ist, dass er eine Schätzung des Effekts einer Änderung um eine Einheit der unabhängigen Variablen x1 auf die abhängige Variable y liefert, wobei die anderen unabhängigen Variablen konstant gehalten werden. Wenn x1 in hohem Maße mit einer anderen unabhängigen Variablen x2 korreliert ist, kann eine Konstanthaltung von x2 eben gerade nicht gelingen, um den Effekt der Änderung von x1 um eine Einheit zu schätzen. Ein weiteres Problem können nach oben verzerrte Standardfehler der Koeffizienten sein. Das kann dazu führen, dass die Nullhypothese fälschlicherweise beibehalten wird (Fehler 2. Art).

3 Analytisches Erkennen von Multikollinearität in SPSS

Für einen ersten Eindruck taugt auch eine grafische Diagnose, die ich in diesem Artikel ausführlich beschreibe. Die analytische Diagnose von Multikollinearität kann nun prinzipiell über zwei Wege vorgenommen werden: zum eine wäre eine Korrelationsmatrix geeignet und zum anderen die Kollinearitätsdiagnose mit VIF-Werten und Toleranz.

3.1 Korrelationsmatrix

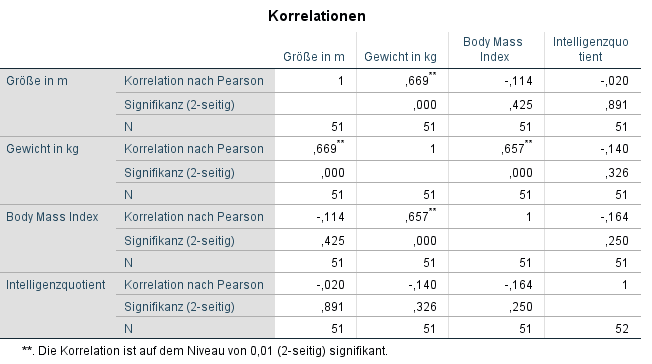

Eine Korrelationsmatrix ist die Streudiagrammmatrix nur in Zahlen ausgedrückt. Sie zeigt den exakten Korrelationskoeffizient (entweder nach Pearson oder Spearman) an. Im Beispiel würde das so aussehen:

In dieser Matrix ist erkennbar, dass keine wirklich bedenklichen Korrelation vorliegen. Die höchste und gleichzeitig statistisch signifikante Korrelation ist 0,669 zwischen Größe und Gewicht. Laut Field, A (2018), S. 402 sind Korrelationswerte über 0,8 ein Anzeichen für Multikollinearität. Sollten also zwei unabhängige Variablen mit 0,8 bzw. -0,8 oder mehr miteinander korrelieren, sollte man sich Gedanken darüber machen, eine der beiden aus der Analyse auszuschließen.

3.2 VIF-Werte und Toleranz

Zu guter Letzt und am belastbarsten ist in meinen Augen die Berechnung der VIF-Werte bzw. der Toleranz. VIF steht für variance inflation factor und wird für jede unabhängige Variable in der Koeffiziententabelle berechnet. Er ist ein Indikator, ob eine hohe Korrelation zwischen einer unabhängigen und mehreren anderen unabhängigen Variablen vorliegt. Hat ein Koeffizient einen VIF-Wert über 10, ist dieser ein Problem und es liegt mit Sicherheit Multikollinearität vor (Kutner et al. (2005), S. 410). Wegen der Beziehung

![]()

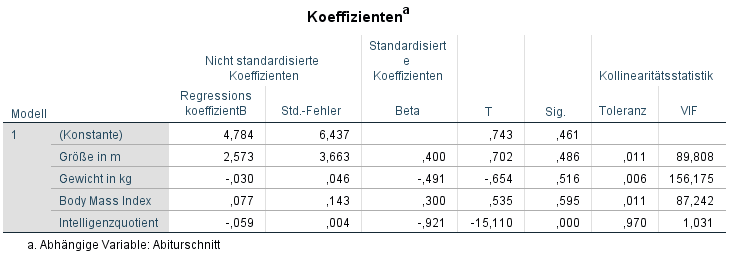

ist eine Toleranz unter 0,1 ebenso ein Anzeichen für Multikollinearität aufgrund des Koeffizienten. Im Beispiel sieht die Koeffiziententabelle so aus:

Hier ist erkennbar, dass Größe, Gewicht und Body Mass Index jeweils VIF-Werte von >10 haben und damit eine hohe Korrelation zwischen jenen vorherrscht, die Multikollinearität zur Folge hat.

4 Was tun bei Multikollinearität?

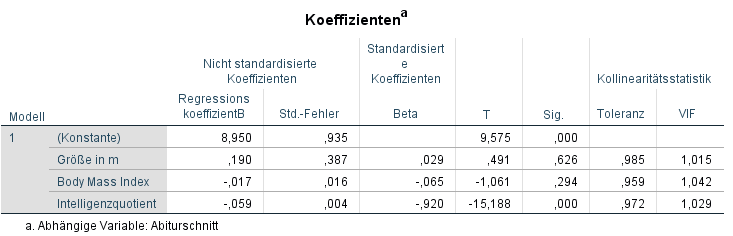

Da sowohl Gewicht mit Größe als auch BMI in der Korrelationstabelle von oben eine recht hohe Korrelation hatte, habe ich entschieden, diese als unabhängige Variable wegzulassen. Inhaltlich kann und sollte man zudem argumentieren, dass im BMI das Gewicht ohnehin zur Berechnung herangezogen wird. Zudem sind größere Menschen sowieso meist schwerer – die Übergewichtigen mal vernachlässigt. Die neue Koeffiziententabelle ohne Gewicht als unabhängige Variable sieht dann wie folgt aus:

Hier ist erkennbar, dass das Löschen von Gewicht als unabhängige Variable im Regressionsmodell der richtige Schritt war. Die VIF-Werte sind alle nahe 1 und damit nicht annähernd nahe dem kritischen Wert von 10. Die Toleranz zeigt entsprechend der oben gezeigten Berechnungsvorschrift logischerweise keine Werte <0,1. Zusammengefasst ist das (inhaltlich) begründete Weglassen von unabhängigen Variablen mit einem hohen VIF-Wert zur Vermeidung von Multikollinearität der richtige Weg. Allein anhand der Streudiagrammmatrix und der Korrelationsmatrix sollte keine Entscheidung getroffen werden.

5 Literatur

- Field, A. P., & Field, A. P. (2018). Discovering statistics using IBM SPSS statistics. London ; Thousand Oaks.

- Kutner, M. H. (2005). Applied linear statistical models. Boston: McGraw-Hill Irwin.

6 Videotutorial